Trong quá trình kiểm tra lại tài liệu chuẩn bị gửi cho khách hàng, anh Quang bất ngờ nhận thấy bản kế hoạch được trình bày rõ ràng, mạch lạc và chuyên nghiệp hơn hẳn so với trước đây. Anh chia sẻ: “Khi hỏi ra, cậu nhân viên mới thú nhận đã sử dụng AI để hỗ trợ làm kế hoạch, thậm chí còn hào hứng kể về cách ‘điều khiển’ AI làm việc.”

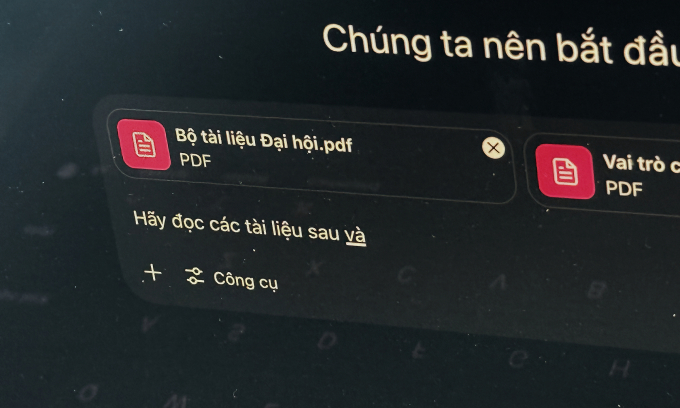

Mặc dù vui mừng vì nhân viên đã biết ứng dụng công nghệ để nâng cao chất lượng công việc, anh Quang không khỏi lo lắng. Để có được bản kế hoạch chi tiết như vậy, nhân viên đã làm theo hướng dẫn trên mạng, tải toàn bộ tệp tin kế hoạch sắp tới lên ChatGPT, bao gồm cả những thông tin bảo mật liên quan đến khách hàng, sản phẩm chuẩn bị ra mắt, chiến lược kinh doanh và ngân sách dự kiến. Đây đều là những thông tin mà đối tác yêu cầu bảo mật tuyệt đối.

Anh Quang bày tỏ: “Tôi không biết liệu ChatGPT có lưu lại những thông tin này không, và dữ liệu đó hiện đang ở đâu. Nhưng chắc chắn một điều rằng, nó không còn là bí mật giữa hai bên nữa. Nhân viên của tôi vẫn ngây thơ tin rằng chỉ cần tiết lộ cho ChatGPT thì người ngoài sẽ không thể biết được.”

Những trường hợp như trên được gọi là “Shadow AI” (AI trong vùng tối), một thuật ngữ dùng để chỉ việc cá nhân hoặc bộ phận trong tổ chức tự ý sử dụng các công cụ trí tuệ nhân tạo mà không có sự cho phép hoặc giám sát của bộ phận công nghệ thông tin. Khái niệm này xuất phát từ “Shadow IT”, khi nhân viên sử dụng các hệ thống công nghệ nằm ngoài sự kiểm soát chính thức của tổ chức.

Trong bối cảnh AI tạo sinh ngày càng được ứng dụng rộng rãi, Shadow AI đang trở thành một mối lo ngại mới đối với các doanh nghiệp. Báo cáo An ninh mạng năm 2025 của Cisco cho thấy 62% tổ chức tại Việt Nam thừa nhận họ thiếu tự tin trong việc phát hiện nhân viên sử dụng AI không được kiểm soát, tức là đang gặp phải tình trạng Shadow AI. Cũng theo khảo sát này, 44% nhân viên tại các tổ chức ở Việt Nam đang sử dụng các công cụ GenAI từ bên thứ ba đã được phê duyệt, nhưng 40% đội ngũ CNTT không nắm được cách nhân viên tương tác với GenAI.

Từng là người khuyến khích nhân viên chủ động sử dụng AI, thậm chí mua tài khoản ChatGPT Plus cho cả phòng dùng chung, anh Nguyễn Hoàng, trưởng phòng kinh doanh tại một công ty khởi nghiệp ở Hà Nội, giờ đây lại lo lắng về việc AI bị lạm dụng.

Trong một lần xem lại lịch sử trò chuyện trên tài khoản chung, anh Hoàng bất ngờ phát hiện một đoạn hội thoại dài, trong đó một nhân viên nhờ AI tư vấn về cách chăm sóc khách hàng. Người này đã “tâm sự” với chatbot toàn bộ thông tin nhạy cảm, từ tình trạng trì trệ của một dự án lớn, phản ứng tiêu cực của khách hàng, đến những khó khăn nội bộ mà công ty đang gặp phải. Anh kể lại: “Nhân viên đó giải thích rằng cần phải nói rõ như vậy thì chatbot mới hiểu và tư vấn chính xác được.”

Mặc dù lo ngại về nguy cơ rò rỉ dữ liệu của công ty, anh Hoàng thừa nhận vẫn đang loay hoay tìm cách ngăn chặn tình trạng này, vì doanh nghiệp còn nhỏ và không có đủ khả năng trang bị các công cụ AI với khả năng bảo mật cao hơn.

Ông Nguyễn Như Dũng, Tổng giám đốc phụ trách Cisco Lào, Việt Nam và Campuchia, nhận định: “Các nhóm an ninh mạng đang phải đối mặt với hai thách thức lớn: làm thế nào để bảo mật quá trình phát triển và triển khai các ứng dụng doanh nghiệp tích hợp AI, đồng thời bảo vệ nhân viên khi họ sử dụng các công cụ AI của bên thứ ba.”

Theo ông Vũ Ngọc Sơn, Trưởng ban Nghiên cứu, tư vấn, phát triển công nghệ và Hợp tác quốc tế của Hiệp hội An ninh mạng quốc gia (NCA), Shadow AI đang trở thành một mối lo ngại lớn về an ninh mạng, ảnh hưởng đến cả ba trụ cột của một hệ thống công nghệ thông tin, bao gồm: con người, quy trình và công nghệ.

Ông Sơn cho biết đã gặp nhiều trường hợp người dùng tại các tổ chức, doanh nghiệp trong nước đưa các tài liệu, mã nguồn nội bộ, kế hoạch kinh doanh, thông tin chiến lược và báo cáo tài chính lên AI để nhờ phân tích hoặc tư vấn. Ông cảnh báo: “Dữ liệu này sẽ được các hệ thống AI sử dụng để huấn luyện và tăng cường khả năng, và có khả năng bị lộ lọt nếu nền tảng AI bị tấn công, xâm nhập hoặc có bảo mật kém.”

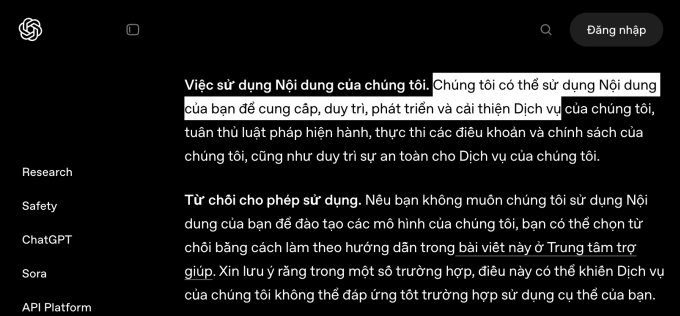

Thực tế, các chatbot AI phổ biến hiện nay như ChatGPT và Gemini đều có điều khoản cho phép thu thập và lưu trữ dữ liệu người dùng nhập vào, nhằm phục vụ mục đích huấn luyện mô hình và cải thiện sản phẩm. Ở chế độ cài đặt mặc định, nội dung hội thoại, bao gồm văn bản, hình ảnh và tệp đính kèm, có thể được hệ thống lưu lại và phân tích, thậm chí có thể bị con người truy cập.

Ví dụ, với ChatGPT, dữ liệu người dùng từ các gói miễn phí mặc định được thu thập để huấn luyện AI. Với gói cao cấp, người dùng có thể tắt tính năng này trong phần cài đặt hoặc sử dụng chế độ “Temporary Chat” để tránh lưu dữ liệu. Tuy nhiên, tính năng bảo vệ quyền riêng tư không được bật sẵn, khiến nhiều người không nhận thức được rủi ro.

Về mặt quy trình, đại diện NCA đánh giá rằng hầu hết các doanh nghiệp và tổ chức hiện nay chưa có quy trình sử dụng AI cụ thể, chẳng hạn như loại dữ liệu nào được phép sử dụng với AI, loại tài liệu nào không được phép, và loại công việc nào cần tránh. Điều này dẫn đến việc sử dụng AI một cách tùy tiện và không kiểm soát. Công nghệ của các AI lớn cũng vượt quá phạm vi hiểu biết của phần lớn các cơ quan và tổ chức sử dụng. Ông Sơn nhận xét: “Họ quan tâm đến sức mạnh của AI mà ít tìm hiểu về các yếu tố an toàn.”

Các chuyên gia đều cho rằng để đối phó với Shadow AI, cần có sự tham gia của cả doanh nghiệp và người sử dụng.

Ông Dũng khuyến nghị các tổ chức cần thiết lập các chính sách và khung làm việc liên quan đến việc sử dụng AI một cách có trách nhiệm. Ngoài ra, họ cần một giải pháp bảo mật AI toàn diện, có thể nhận diện ai đang sử dụng AI, các tài nguyên huấn luyện AI mà họ dùng, cũng như các công cụ đã được phê duyệt hoặc chưa được phê duyệt.

Đồng tình với quan điểm này, ông Vũ Ngọc Sơn cho rằng các tổ chức và doanh nghiệp cần sớm nghiên cứu và ban hành các chính sách, định hướng sử dụng AI an toàn, đồng thời tăng cường đào tạo và giám sát theo đúng các quy định đã đặt ra. Ông Sơn nhấn mạnh: “Khi đưa dữ liệu lên AI, hãy xác định xem dữ liệu đó có thể được sử dụng rộng rãi hay không, từ đó đánh giá mức độ ảnh hưởng để biết những thông tin gì nên hỏi và những gì không nên, hoặc khi hỏi cần mã hóa hoặc xóa bỏ thông tin gì.”

Ngoài ra, chuyên gia từ NCA cho rằng cần có sự tham gia của các cơ quan quản lý trong việc sớm xây dựng các tiêu chuẩn về các hệ thống AI được phép sử dụng, tùy theo mức độ quan trọng của hệ thống thông tin.

Trên thế giới, Shadow AI cũng là một mối quan tâm của nhiều doanh nghiệp và quốc gia. Theo Axios, tại Mỹ, nỗi lo này càng gia tăng khi DeepSeek giá rẻ ra mắt vào đầu năm, thu hút nhiều người sử dụng. Một số tổ chức đã cấm nhân viên sử dụng chatbot AI để hạn chế nguy cơ rò rỉ thông tin.

Ông Dũng kết luận: “Việc nâng cao nhận thức cho nhân viên về những rủi ro của Shadow AI là rất quan trọng, đặc biệt khi chỉ có 55% người tham gia khảo sát tại Việt Nam cho rằng nhân viên của họ thực sự hiểu rõ các mối đe dọa liên quan đến AI.”

Admin

Nguồn: VnExpress